Astroturfing im Zeitalter von Live‑KIs

Wie künstliche „Basisbewegungen“ Maschinen und Gesellschaft aus dem Tritt bringen

Einleitung: Warum das Thema gerade jetzt brisant ist

KI‑Assistenten, die mit Echtzeitdaten aus sozialen Netzwerken arbeiten, versprechen besonders aktuelle Antworten. Systeme wie xAI’s Grok verknüpfen laut Hersteller Live‑Suche über X (ehemals Twitter), das Web und Newsfeeds – ein starker Nutzen, aber auch eine offene Flanke: Was in die Feeds eingespeist wird, prägt die Antworten. Verzerren koordinierte Manipulationskampagnen die Signale, kann die KI diese Verzerrungen übernehmen – und damit Fehleindrücke verstärken, statt sie zu korrigieren.

Was Astroturfing ist – und was es von echter Grassroots‑Unterstützung unterscheidet

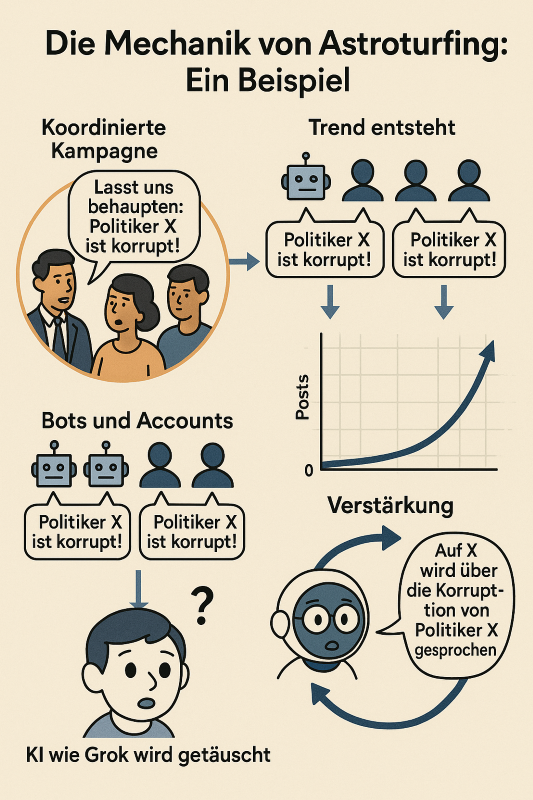

Astroturfing bezeichnet inszenierte, verdeckte Meinungsbildung, bei der organisierte Akteure eine künstliche Welle von Zustimmung oder Empörung erzeugen, um sie als „Stimme der Basis“ auszugeben. Das Spektrum reicht von Sockenpuppen‑Netzwerken, bezahlten Kommentator:innen und Front‑Organisationen bis zu Bot‑Farmen, die Hashtags pushen, Themen „trenden“ lassen oder massenhaft scheinbar unabhängige Bewertungen und Posts streuen. Entscheidend ist nicht ein einzelner falscher Beitrag, sondern die orchestrierte Illusion eines Konsenses – ein Kunstrasen, der echte Graswurzeln imitiert.

Warum Echtzeit‑KIs besonders verwundbar sind

KIs mit Live‑Anbindung an Social‑Media‑Ströme lesen nicht nur Texte – sie gewichten auch, was Aufmerksamkeit bekommt: Trending‑Topics, Interaktionen, Wiederholungen. Genau hier setzt Astroturfing an. Wird eine Plattform mit koordinierten Signalen überflutet, kann eine KI Scheinmehrheiten als Realität interpretieren. Im Ergebnis verschiebt sich, was „viel diskutiert“ oder „mehrheitsfähig“ erscheint – und zwar innerhalb von Minuten, nicht erst über Monate.

Zugleich wirkt eine zweite, subtilere Gefahr: Auch ohne Lügen kann Wiederholung den Wahrheits‑Eindruck erhöhen. Wenn orchestrierte Akteure eine Behauptung über viele Accounts immer wieder äußern, steigt deren gefühlte Plausibilität – für Menschen ebenso wie für Systeme, die Beliebtheitssignale als Relevanz deuten. So entstehen Stimmungsverzerrungen, die eine Echtzeit‑KI aufgreifen und in Antworten weitertragen kann.

Die Angriffsflächen entlang der KI‑Pipeline

→ Erstens: Signal‑Vergiftung. Social Bots beschleunigen nachweislich die Verbreitung „low‑credibility“-Inhalte, besonders in der frühen Phase, wenn Trends entstehen. Für eine KI, die Trends als Priorisierungs‑Signal nutzt, ist das eine Rezeptur für Fehlgewichtungen.

→ Zweitens: Wissens‑Vergiftung in RAG‑Systemen. Viele moderne Assistenten kombinieren Generierung mit Abruf externer Quellen (Retrieval‑augmented Generation). Forschung zeigt, dass wenige gezielt platzierte, giftige Texte im Abruf‑Korpus genügen können, um Wunschantworten auf bestimmte Fragen den Weg zu bahnen.

→ Drittens: Indirekte Prompt‑Injection. Inhalte im Web (inkl. Social Posts) können versteckte Anweisungen enthalten, die – wenn ungeprüft verarbeitet – die Schutzmechanismen der KI unterlaufen. Für Systeme, die Webinhalte automatisch zusammenfassen, ist das ein reales Supply‑Chain‑Risiko.

→ Viertens: Feedback‑Manipulation. Wo Plattform‑ oder Nutzer‑Signale (Likes, Replies) in Ranking, Training oder „Feintuning durch Nutzung“ einfließen, lassen sich Bot‑Brigaden zur Verstärkung missbrauchen – scheinbare „Qualität“ wird künstlich bestätigt.

→ Fünftens: Datenkontamination im Training. Wenn Plattformen von synthetischen oder manipulierten Inhalten durchsetzt sind und diese später in Trainingsdatensätze zurückfließen, drohen langfristige Qualitätsverluste („Model Collapse“) oder persistent falsche Assoziationen.

Politische Kontexte: Von Scheinkonsens zu Polarisierung

Astroturfing entfaltet seine größte Wirkung dort, wo soziale Wahrnehmung das Verhalten lenkt – in der Politik. Netzwerkeffekte erzeugen die „Mehrheitsillusion“: Was in meinem Umfeld (künstlich) häufig wirkt, halte ich für normal oder mehrheitsfähig. Dazu kommt die Illusory‑Truth‑Dynamik: Wiederholte Behauptungen fühlen sich wahrer an, selbst wenn man es besser weiß. In Kombination entsteht ein Scheinklima der Meinung, das Journalist:innen, Entscheidungsträger und KI‑Systeme als „Stimmung“ spiegeln – und damit weiter verstärken.

Dass solche Operationen nicht theoretisch sind, belegen wiederholte Takedowns koordinierter Netzwerke. 2023 meldete Meta die bislang größte plattformübergreifende Beeinflussungsoperation („Spamouflage“) mit Tausenden von Accounts über mehr als 50 Plattformen. 2024 berichtete das US‑Justizministerium, man habe eine KI‑gestützte russische Bot‑Farm mit rund 1.000 X‑Konten zerschlagen. Parallel kritisierte die EU‑Kommission X/Twitter als Plattform mit dem höchsten Anteil an Desinformation unter den großen Diensten – ein Hinweis darauf, dass schon das Grundrauschen problematisch sein kann, wenn KIs es ungefiltert auswerten.

Folgen für das politische Klima

Auf Gesellschaftsebene sind die Folgen nicht nur kurzfristig kommunikativ, sondern strukturell: Erosion von Vertrauen in Medien und Institutionen; Polarisierung durch verstärkte Sichtbarkeit von Randpositionen; Agenda‑Verschiebungen, wenn Nachrichten‑ und KI‑Ökosysteme künstlich gepushte Themen übergewichten. Die Politikwissenschaft und Thinktanks beschreiben diese Entwicklung als „Truth Decay“ – die schwindende Rolle von Fakten und Analyse in der öffentlichen Debatte, mit Blockaden in der Politik als Folgekosten.

Was robuste KI‑Systeme und Plattformen jetzt tun sollten

- Mehr‑Quellen‑Absicherung statt Single‑Feed. Behauptungen und Trends sollten quergeprüft werden (unabhängige Medien, Primärdokumente, Fact‑Checks), bevor sie Antworten prägen.

- RAG absichern. Abruf‑Korpora brauchen Provenienz‑Kontrollen, kuratierte Whitelists, toxizitäts‑ und neuigkeitsbewusste Deduplikation sowie regelmäßige Red‑Team‑Tests gegen Poisoning‑Angriffe.

- Prompt‑Injection abwehren. Webinhalte als untrusted behandeln: strikte Trennung von Lese‑ und Aktionsfähigkeiten, Output‑Filter und Policy‑Gates sowie Mustererkennung für „versteckte Anweisungen“.

- Engagement‑Signale entgiften. Graph‑basierte Anomalieerkennung und Bot‑Indikatoren (z. B. via OSoMe‑Tools) sollten Gewichte senken, statt Gefolgschaften zu belohnen.

- Inhalts‑Provenienz fördern. Content Credentials (C2PA) helfen, Herkunft belegbar zu machen. Sie ersetzen keine Wahrheit, erhöhen aber Nachvollziehbarkeit – und damit die Resilienz gegen manipulative Wiederverwendung.

- Trainingsdaten‑Hygiene. Synthetische Anteile kennzeichnen und begrenzen, Web‑Scrapes auf praktische Datenvergiftung prüfen und „Rückfluss“ aus generierten Inhalten kontrollieren.

Quintessenz

Astroturfing ist kein Randphänomen, sondern eine skalierbare Technik, die sich präzise an die Schwachstellen moderner Informationssysteme legt – von menschlicher Kognition bis zur Architektur von Live‑KIs. Je direkter ein Modell am Takt öffentlicher Feeds hängt, desto wichtiger werden Provenienz, Korpuskontrolle und robuste Sicherheitsmechanismen. Wer die demokratische Diskursfähigkeit sichern will – Plattformen, Behörden, Medien, und KI‑Anbieter – muss diese Verteidigung gemeinsam organisieren.

Quellen

- Echtzeit‑Anbindung von Grok (xAI‑Ankündigung)

- Astroturfing/Computational Propaganda – Einordnung (Oxford Internet Institute)

- Definition „Astroturfing“ (Merriam‑Webster)

- Bots beschleunigen Low‑Credibility‑Inhalte (Shao et al., Nature Communications 2018)

- Falschmeldungen verbreiten sich schneller als Wahres, besonders politisch (Vosoughi/Roy/Aral, Science 2018; MIT‑PDF)

- „Mehrheitsillusion“ in Netzwerken (Lerman/Yan/Wu, PLOS One 2016)

- Illusory Truth Effect (Übersicht) (Current Opinion in Psychology, 2023)

- US‑DoJ zerschlägt KI‑gestützte russische Bot‑Farm (≈ 1.000 X‑Konten) (DoJ‑Mitteilung; ergänzend Reuters)

- „Spamouflage“ – größte bekannte plattformübergreifende Einfluss‑Operation (TIME/AFP‑Bericht)

- EU‑Bewertung: X mit höchstem Desinformations‑Anteil (Jourová‑Aussage, Forbes‑Bericht)

- RAG‑Poisoning („PoisonedRAG“) – USENIX Security 2025 (Paper/Proceedings)

- Prompt‑Injection‑Risiken und Gegenmaßnahmen (OWASP LLM Top‑10; Microsoft MSRC‑Blog)

- Content‑Provenienz/C2PA (c2pa.org; TikTok‑Einführung von Content‑Credentials)

- Bot‑Indikatoren/Tools (OSoMe, Botometer X)

- „Truth Decay“ – Erosion der Rolle von Fakten (RAND‑Projekt/Report)

→ Hinweis: Die genannten Quellen dokumentieren Mechanismen (Bots, Desinformation, Netzwerk‑Illusionen), konkrete Operationen (Spamouflage; DoJ‑Takedown) und Sicherheitsrisiken für KI‑Pipelines (RAG‑Poisoning, Prompt‑Injection) sowie Gegenmaßnahmen (Provenienz, Härtung von Abruf‑Korpora).